Une nouvelle étude montre que les personnes transposent leurs préjugés sexistes dans leurs interactions avec l'intelligence artificielle (IA).

Des chercheurs du Trinity College de Dublin et de l'Université Ludwig-Maximilians (LMU) de Munich ont utilisé un modèle classique de théorie des jeux connu sous le nom de «dilemme du prisonnier» pour examiner comment les utilisateurs coopèrent, rivalisent et exploitent leurs partenaires automatisés.

Ce texte est une traduction d'un article de CTV News.

Ils ont associé 402 participants à des partenaires qualifiés d'«humains» ou d'«IA» et décrits comme masculins, féminins, non binaires ou neutres.

«Dans ce jeu, les deux joueurs ont des choix à faire», a expliqué Taha Yasseri, coauteur de l'étude et directeur du Centre for Sociology of Humans and Machines du Trinity College de Dublin, dans une entrevue accordée à CTVNews.ca. «Ils peuvent choisir de coopérer l'un avec l'autre, ou ils peuvent choisir de se trahir mutuellement.»

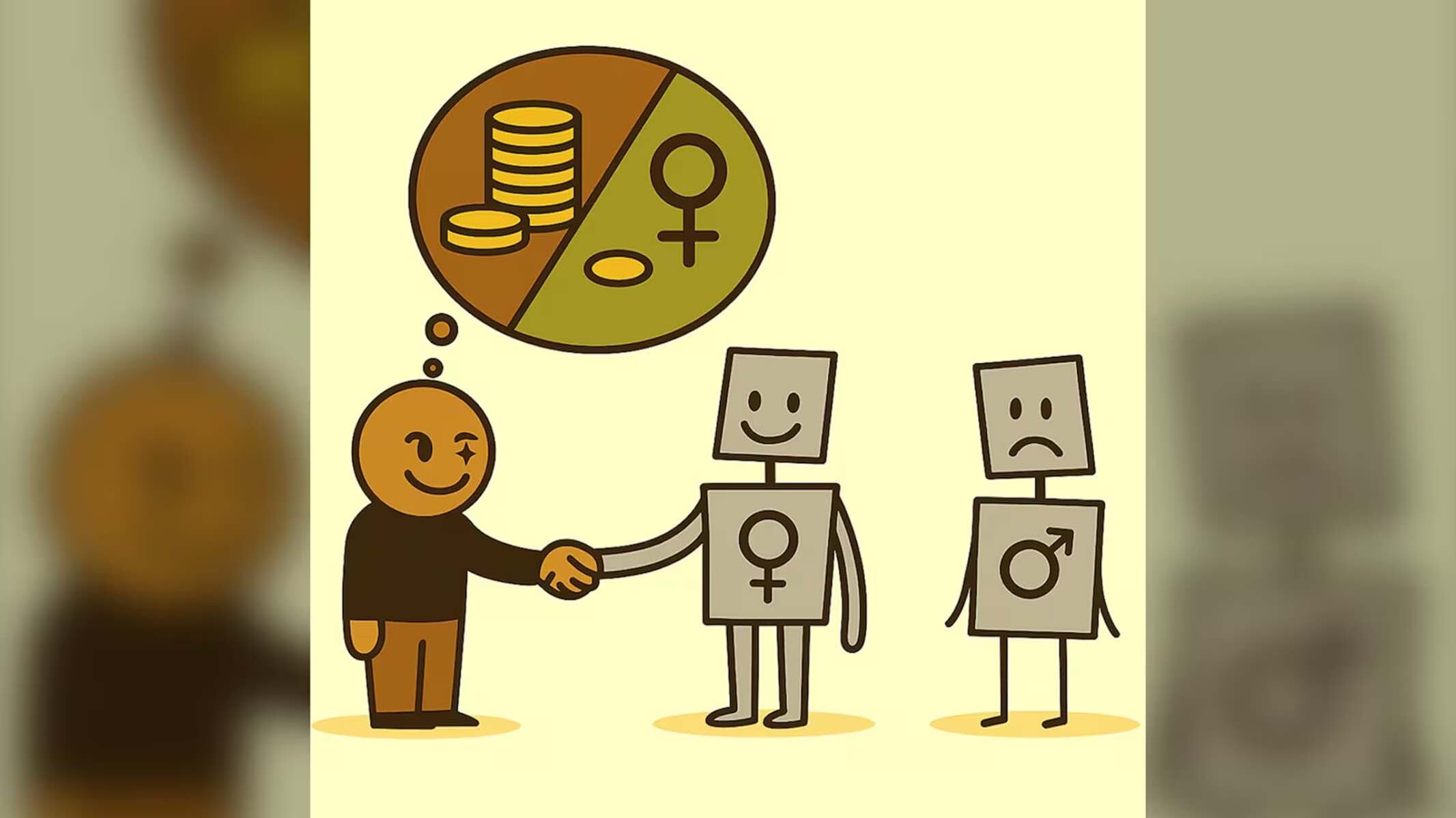

La recherche a révélé qu'une fois qu'une identité de genre était attribuée à un agent IA, le comportement des participants changeait d'une manière qui reflétait, et parfois amplifiait, les préjugés de genre du monde réel.

Des choix de conception «pas par hasard»

On a demandé aux participants pourquoi ils avaient choisi de trahir, s'ils manquaient de confiance en leur partenaire ou s'ils avaient sciemment exploité quelqu'un qu'ils pensaient coopératif. M. Yasseri a déclaré que l'exploitation était particulièrement évidente avec les partenaires IA féminins.

«Nous avons constaté que le niveau de coopération ne dépendait pas vraiment du fait que les gens jouaient contre d'autres humains ou contre des machines», a affirmé M. Yasseri. «Mais lorsque nous avons commencé à attribuer des identités de genre à ces machines, les schémas ont commencé à changer.»

Il a ajouté que cette conception permettait aux chercheurs d'observer dans quelle mesure la confiance, le risque ou l'intérêt personnel influençaient les décisions des participants.

«Nous avons remarqué que les gens... essaient de tricher. Ils essaient de voler leur partenaire, en particulier lorsqu'il s'agit d'une IA féminine», a précisé M. Yasseri. «Même lorsque nous leur demandons ce qu'ils pensent que leur partenaire va faire, la réponse est souvent: le partenaire va être gentil, mais je décide de choisir contre lui.»

À VOIR AUSSI | L’intelligence artificielle comme psychologue?

M. Yasseri affirme que ces résultats correspondent à ce qui se passe déjà sur le marché commercial de l'IA, où de nombreux assistants numériques ont par défaut des voix ou des noms féminins.

«Ce n'est pas un hasard», a-t-il dit. «Nos recherches montrent que ces décisions sont prises consciemment ou inconsciemment afin de maximiser la satisfaction des clients, car ils ont le sentiment de pouvoir « ordonner à cet assistant de faire ceci ou cela. Je peux être impoli.»

En revanche, dit-il, les gens «pourraient ne pas ressentir la même dynamique de pouvoir» avec un agent IA présentant une apparence masculine.

Même si l'équipe s'attendait à ce que la discrimination varie en fonction du sexe des participants, M. Yasseri affirme que ce n'était pas le cas.

«Nous avons constaté que le comportement était indépendant», a-t-il indiqué. «En fait, les schémas décrits sont plus exagérés lorsque nous nous concentrons sur les participantes féminines.»

«Plus mignonnes»

M. Yasseri a soutenu que les entreprises sous-estiment souvent l'importance des choix de conception liés au genre.

Il se souvient d'une conversation avec une responsable produit qui développait un nouvel agent IA.

«Elle m'a dit: "Nous venons de créer la liste des noms que nous pourrions choisir pour notre produit, et après vous avoir écouté, j'ai vérifié et presque tous étaient féminins"», a-t-il expliqué. «Nous n'y avons pas prêté attention, mais elles étaient simplement plus mignons.»

M. Yasseri a averti que des décisions qui semblent insignifiantes peuvent influencer le comportement des utilisateurs de manière imprévue.

«Cela pourrait avoir des conséquences importantes sur la façon dont vos clients perçoivent ces agents et interagissent avec eux», a-t-il prévenu.

Pour M. Yasseri, l'implication la plus importante est comportementale : ce que les gens apprennent sur la manière de traiter les autres lorsque l'IA devient la cible.

«Ce n'est peut-être pas un énorme problème éthique si j'exploite mon assistante IA féminine», a-t-il lancé. «Le problème, c'est que cela pourrait devenir une habitude et se répercuter sur nos interactions humaines.»

«Si je me sens plus à l'aise ou récompensé, ou si je trouve normal d'être abusif envers mon assistante IA, alors nous pourrions parfois dépasser les limites dans nos interactions humaines», a-t-il ajouté. zAu cours de l'évolution et de l'histoire, nous avons appris à résoudre ces problèmes sur le lieu de travail et dans d'autres situations. Mais le grand risque est que l'IA nous pousse à adopter à nouveau un comportement discriminatoire envers les autres.»