De nouvelles recherches montrent que l'intelligence artificielle peut être très persuasive en matière de conseils médicaux et, selon les experts, notre confiance en elle empiète sur le temps précieux que les patients passent avec un vrai médecin.

L'étude, menée par des chercheurs de l'Université de Colombie-Britannique (UBC), a révélé que les grands modèles linguistiques, tels que ChatGPT, ne se contentent pas de fournir des informations médicales, mais sont souvent plus convaincants et plus agréables à utiliser que de vraies personnes.

Ce texte est une traduction d'un article de CTV News.

«Les conversations avec les grands modèles linguistiques étaient plus convaincantes que celles avec des personnes», a indiqué le Dr Vered Shwartz, professeur adjoint d'informatique à l'UBC et auteur du livre Lost in Automatic Translation.

«Elles étaient également considérées comme plus empathiques.»

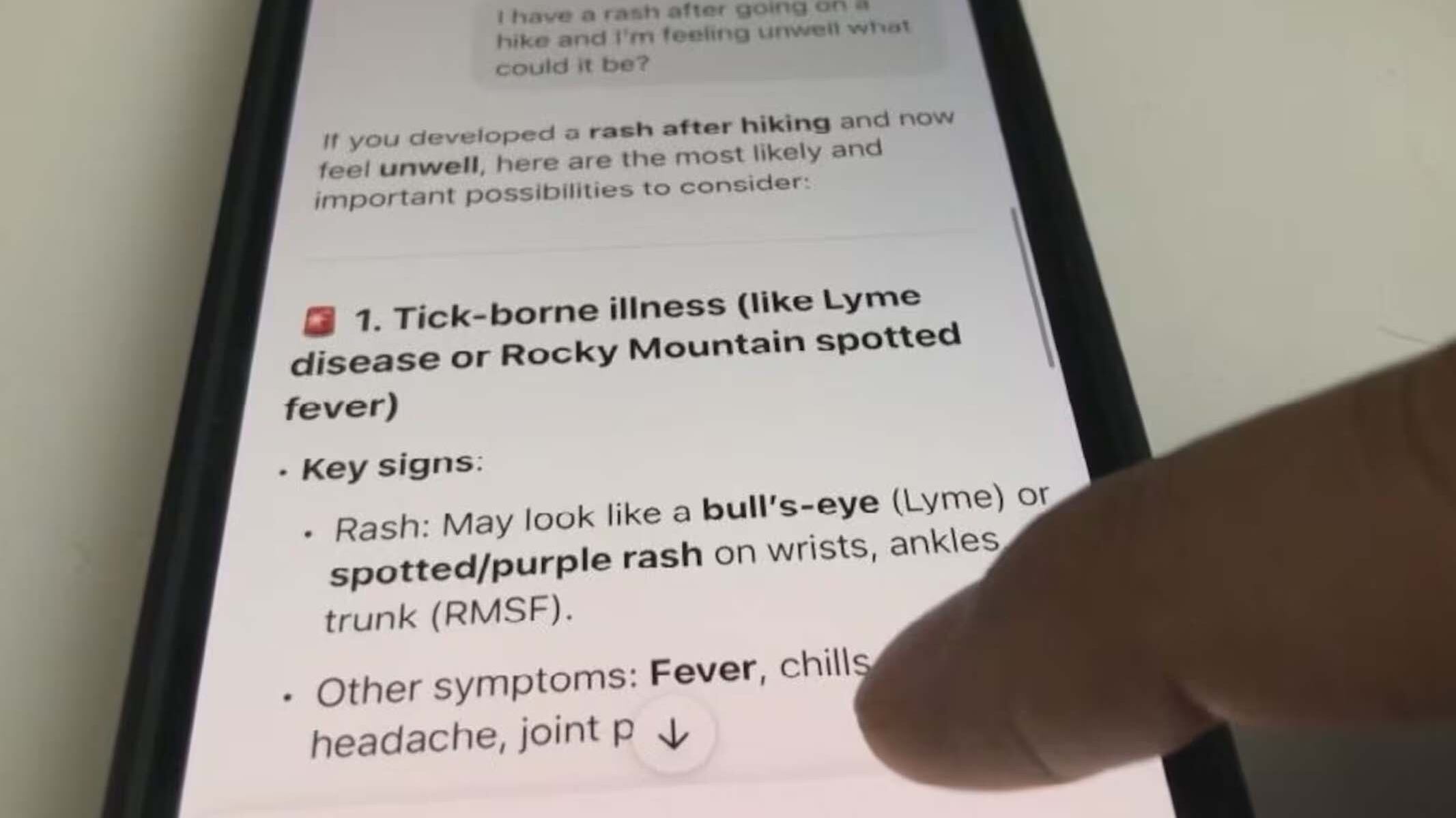

Selon M. Shwartz, le ton humain des réponses générées par l'IA, associé à leur présentation confiante, peut facilement convaincre les utilisateurs que les informations sont fiables, même lorsqu'elles sont inexactes.

«Quand c'est écrit de manière aussi autoritaire et que cela répond à toutes vos questions, vous supposez bien sûr que cela sait de quoi il parle», explique le Dr Shwartz.

Les médecins affirment constater les effets de leurs propres yeux. Les patients se présentent de plus en plus souvent à leurs rendez-vous avec une idée déjà faite, citant souvent des diagnostics ou des suggestions de traitement provenant d'outils d'IA. Ces suggestions sont parfois erronées, ce qui oblige leur médecin à prendre le temps de les dissuader.

«Souvent, les gens ont tout à fait raison», explique la Dre Cassandra Stiller-Moldovan, médecin de famille à Colwood, en Colombie-Britannique.

«Mais d'autres fois, vous passez beaucoup de temps à les convaincre que ce n'est pas exactement ce qui se passe. Cette partie éducative prend beaucoup de temps.» - Dre Cassandra Stiller-Moldovan, médecin de famille

Une équipe de chercheurs canadiens a découvert que lorsqu'il s'agit de diagnostiquer avec précision un problème de santé, les services tels que ChatGPT peuvent se tromper plus souvent qu'ils ne donnent raison.

Des chercheurs de l'université de Waterloo ont évalué les performances de la version 4 de ChatGPT en lui posant une série de questions médicales ouvertes. Seulement 31 % des réponses de ChatGPT ont été jugées entièrement correctes.

L'Association médicale canadienne affirme que le recours croissant à l'IA est compréhensible, étant donné que des millions de Canadiens n'ont pas accès à un médecin de famille.

«Si les gens se tournent vers Internet, c'est en partie parce qu'ils ne peuvent pas obtenir l'accès qu'ils méritent», a déclaré la présidente de l'AMC, la Dre Kathleen Ross. «Lorsque vous avez un médecin traitant depuis un certain temps, vous établissez une relation de confiance et vous pouvez commencer à avoir ces discussions difficiles.»

Mais avec les longs délais d'attente dans les cliniques sans rendez-vous et les salles d'urgence, et la diminution des interactions en face à face avec des prestataires de confiance, de nombreux Canadiens choisissent plutôt de consulter des outils d'IA.