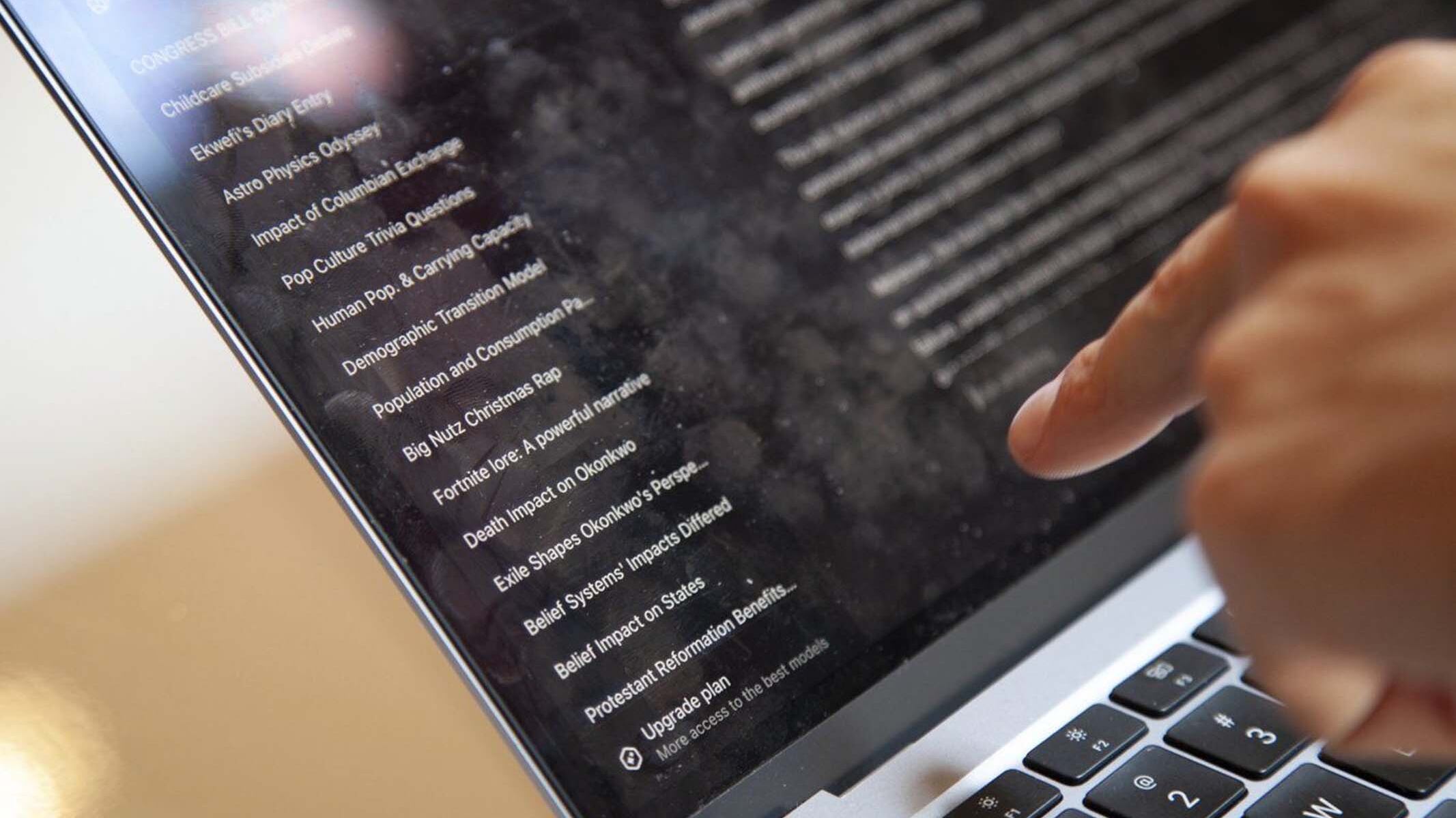

De plus en plus d'employés utilisent des outils d'intelligence artificielle (IA) pour accomplir leurs tâches et accroître leur productivité, mais, la plupart du temps, ces outils ne sont pas approuvés par les entreprises.

L'utilisation de plateformes et d'outils d'IA non autorisés est appelée «intelligence artificielle fantôme». Elle crée un risque de divulgation accidentelle de données internes sensibles, rendant l'entreprise vulnérable aux cyberattaques ou au vol de propriété intellectuelle.

Souvent, les entreprises tardent à adopter les dernières technologies, ce qui peut inciter les employés à recourir à des solutions tierces, comme des assistants d'IA, rapporte Kareem Sadek, associé au sein du groupe de consultation de KPMG au Canada, spécialisé en risques technologiques.

Il indique que l’«intelligence artificielle fantôme» s'infiltre souvent lorsque les utilisateurs recherchent de la commodité, de la rapidité et de l’intuitivité.

Ces outils non autorisés représentent cependant un casse-tête pour les entreprises canadiennes, peu importe leur taille.

«Les entreprises peinent à garantir la protection de leur propriété intellectuelle et à ne pas divulguer d'informations sensibles sur leurs pratiques commerciales, leurs clients et leurs bases d'utilisateurs», affirme Robert Falzon, responsable de l'ingénierie chez Check Point Software Technologies.

Ce que beaucoup d'utilisateurs d'IA ignorent, c'est que, lorsqu'ils interagissent avec des robots conversationnels, leurs conversations et leurs données sont stockées et utilisées pour perfectionner ces outils, souligne M. Falzon.

Par exemple, un employé pourrait partager des états financiers confidentiels ou des recherches exclusives avec des robots conversationnels non autorisés pour générer des infographies, ignorant que les chiffres de vente sont désormais accessibles à des personnes extérieures à l'entreprise, qui pourraient tomber sur ces données en effectuant des recherches sur le même sujet, ignorant qu'elles ne sont pas censées être accessibles au public.

«Il est possible que l'IA fouille dans ses ressources et trouve des informations sur votre entreprise qui présentent les résultats et les transmette nonchalamment à cette personne», indique M. Falzon. Les pirates informatiques utilisent les mêmes outils que tout le monde, avertit-il.

Un rapport publié en juillet par IBM et le centre de recherche américain en cybersécurité Ponemon Institute révèle que 20 % des entreprises ont subi une violation de données en raison d'incidents de sécurité impliquant l'«IA fantôme». C'est sept points de pourcentage de plus que celles ayant subi des incidents de sécurité impliquant des outils d'IA autorisés.

Le coût moyen d'une violation au Canada entre mars 2024 et février 2025 a grimpé de 10,4 %, passant de 6,32 à 6,98 millions $, selon le rapport.

Il est donc nécessaire d'établir une gouvernance autour de l'utilisation de l'IA au travail, selon M. Sadek. Il considère que «ce n'est pas nécessairement la technologie qui fait défaut, c'est le manque de gouvernance».

Cela pourrait impliquer la création d'un comité d'IA composé de personnes issues de différents services, comme les services juridiques et le marketing, afin d'examiner les outils et d'encourager leur adoption en mettant en place des garde-fous appropriés.

M. Sadek indique que ces garde-fous devraient s'appuyer sur un cadre d'IA conforme à l'éthique de l'entreprise et permettant de répondre à des questions complexes, tels que la sécurité, l'intégrité des données et les biais.

L'adoption d'une approche «confiance zéro» pourrait par exemple être envisagée, suggère M. Falzon. Cela signifie de ne faire confiance à aucun appareil ni à aucune application qui ne sont pas explicitement autorisés par l'entreprise.

Cette pratique réduit les risques et limite les informations qu'un appareil autorise ou non un employé à soumettre à un robot conversationnel. M. Falzon rapporte comme exemple que les employés de Check Point ne sont pas autorisés à saisir des données de recherche et développement. S'ils le font, le système les limitera et les informera des risques.

«Cela permet de s'assurer que les clients sont informés et comprennent les risques qu'ils prennent, mais aussi, en aval, de s'assurer que ces risques sont atténués par une protection technologique», explique-t-il.

La sensibilisation est essentielle pour apaiser les tensions entre employeurs et employés concernant les outils d'IA, selon les experts.

M. Sadek souligne que l'organisation de séances de formation pratique et la sensibilisation des employés aux risques liés à l'utilisation d'outils d'IA non autorisés peuvent être utiles.

«Cela réduit considérablement leur utilisation et responsabilise les utilisateurs et les employés. Ils se sentent responsables, surtout s'ils sont formés et sensibilisés aux risques.»

Une solution intelligente

Afin de conserver les données au sein de leurs systèmes internes, certaines entreprises ont commencé à déployer leurs propres robots conversationnels.

Selon M. Sadek, il s’agit d'une solution intelligente pour lutter contre les outils d'IA non autorisés.

«Cela aide les entreprises à garantir une sécurité et une confidentialité accrues de leurs données, et à garantir qu'elles respectent les protections déjà en place au sein de leur organisation.»

Les outils internes ne peuvent cependant pas éliminer complètement les risques.

Le chercheur Ali Dehghantanha rapporte qu'il ne lui a fallu que 47 minutes pour s'introduire dans le robot conversationnel interne d'une entreprise du Fortune 500 et accéder aux informations sensibles de ses clients lors de son audit de cybersécurité. L'entreprise l'a embauché pour évaluer la sécurité de son robot conversationnel interne et vérifier si le système pouvait être manipulé afin de révéler des données sensibles.

«Par sa nature, le robot avait accès à un grand nombre de documents internes de l'entreprise, ainsi qu'aux communications de différents partenaires», note M. Dehghantanha, professeur à l'Université de Guelph, en Ontario, et titulaire de la Chaire de recherche du Canada en cybersécurité et en renseignement sur les menaces.

Il a observé que les grandes banques, les cabinets d'avocats et les entreprises de la chaîne d'approvisionnement s'appuient largement sur les robots conversationnels internes pour obtenir des conseils, répondre aux courriels et communiquer à l’interne, mais que nombre d'entre eux manquent de sécurité et de tests adéquats.

Les entreprises doivent prévoir un budget lorsqu'elles adoptent une technologie d'IA ou déploient leurs propres outils internes, ajoute M. Dehghantanha.

«Pas seulement pour l'IA, mais pour toute technologie, il faut toujours tenir compte du coût total de possession. Une partie de ce coût de possession réside dans la manière de sécuriser et de protéger l'IA. Pour l'IA, ce coût est actuellement considérable», affirme-t-il.

M. Falzon indique que «les entreprises ne peuvent plus empêcher leurs employés d'utiliser l’IA et doivent donc leur fournir les outils dont ils ont besoin».

Il ajoute que «parallèlement, les entreprises veulent s'assurer que des incidents comme les fuites de données ne se produisent pas et que les outils d’IA ne créent pas un risque plus important que les avantages qu'ils offrent».